Continual Learning이 AGI로의 핵심일까?

- 한눈에 보는 핵심요약

- - AI의 고질병 Catastrophic Forgetting이 무엇인지 정리했습니다. - 이를 해결하기 위한 Continual Learning의 필요성과 최신 연구를 소개합니다. - Google의 Nested Lea

안녕하세요, 에디터 쏘입니다 :)

오늘은 AI의 난제 중 하나인 **Continual Learning(지속학습)**에 대해 이야기해 보려고 합니다. 이는 모델이 한 번 학습으로 끝나는 게 아니라, 실제 사용 환경에서 들어오는 새로운 정보를 계속 학습하고 업데이트할 수 있는 것을 의미합니다.

OpenAI 창립 멤버이자 Tesla의 Autopilot Vision 팀을 이끌었던 **안드레 카르파시(Andrej Karpathy)**는 “지금은 '에이전트의 해(Year)'가 아니라 '에이전트의 10년(Decade)이다”라고 말하며, 향후 10년간의 점진적인 개선이 필요하다고 봤습니다.

또한 그는 현재 AI의 결정적인 한계로 Continual Learning의 부재를 지적했습니다. 즉, 지금의 AI는 입력을 그 세션의 Context Window 안에서는 활용할 수 있지만, 세션이 끝난 뒤 그 내용을 모델의 장기 파라미터에 통합하지는 못한다는 겁니다. ChatGPT 같은 서비스는 새 대화에서도 이전 맥락을 아는 것처럼 보일 수 있는데, 이는 모델이 대화 간 정보를 전혀 못 쓰는 게 아니라, 메모리 기능(저장된 메모리, 채팅 기록 참조)으로 과거 정보를 불러와 응답을 만들기 때문입니다. 이건 모델이 상호작용 경험으로 스스로 학습해서 모델 가중치 내부에 영속적으로 통합하는 Continual Learning과는 다릅니다.

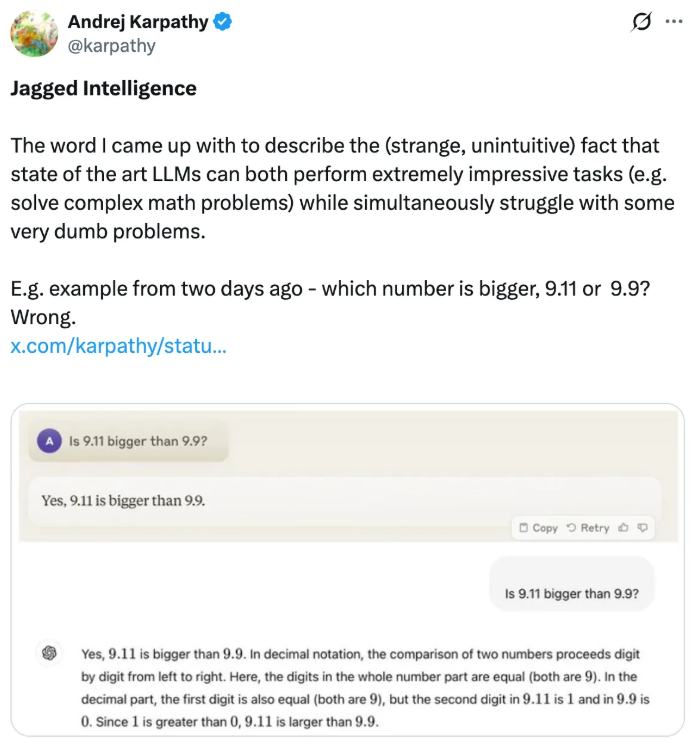

Google DeepMind의 CEO인 **데미스 허사비스(Demis Hassabis)**도 역시 이에 동의합니다. 그는 올해 초 세계 경제 포럼에서 “이 문제는 아직 풀리지 않았다”라고 언급하며, Gemini 같은 파운데이션 모델은 점점 더 나아지고 있으나 한편으로는 완전한 AGI에 도달하려면 아직 빠져 있는 능력들이 있다고 말합니다. 그러면서 현재의 LLM은 **‘Continual Learning도 못 하고, 진정한 창의성도 아직 없으며, 장기적인 계획 수릭과 추론도하지 못한다’**라고 언급했습니다. 그리고 AI가 이런 능력을 갖추었을 때 AI의 들쭉날쭉한 지능(Jagged Intelligence) 문제는 점차 줄어들고, 일관된 지능에 가까워질 것이고 보았습니다.

💡들쭉날쭉한 지능(Jagged Intelligence)

출처: https://x.com/karpathy/status/1816531576228053133

카르파시가 지적한 현상으로, AI가 올림피아드처럼 고난도 수학 문제는 척척 풀면서 "9.11과 9.9 중 뭐가 더 큰가?" 같은 단순한 질문에는 엉뚱한 답을 내놓는 불안정한 현상을 말합니다.

허사비스도 이 비일관성 문제를 해결하려면 데이터와 컴퓨팅을 확장하는 것 이상이 필요하며, 추론, 계획, 기억에서 아직 해결되지 않은 누락된 능력들이 있다고 덧붙였습니다.

허사비스는 이 들쭉날쭉함의 원인 중 하나로 Continual Learning의 부재를 꼽으며, 이것이 해결되지 않으면 AGI에 도달할 수 없다고 말합니다.

Catastrophic Forgetting: AI의 치명적 건망증

Catastrophic Forgetting은 AI 모델이 새로운 데이터나 태스크를 학습할 때 이전에 학습했던 지식이 급격히 사라지는 현상입니다. 이는 1989년 마이클 맥클로스키(Michael McCloskey)와 닐 코헨(Neal Cohen)의 연구에서 처음 정립된 이래, 30년이 넘도록 신경망 연구의 근본적인 난제로 남아 있습니다.

왜 이런 일이 발생할까요? 현재의 딥러닝 모델은 여러 기능을 하나의 파라미터(W)에 동시에 저장합니다. 예를 들어, 모델이 영어 번역(Task A)에 맞춰 학습된 뒤, 의료 문서 요약(Task B)을 새로 학습시키면, Task B를 위해 파라미터가 수정되는 과정에서 Task A를 위해 최적화되었던 값들이 덮어쓰입니다. 즉, 새 테스크에 대한 최적화가 기존 태스크와 간섭(Interference)을 일으키는 것입니다.

이 문제는 특히 SFT(Supervised Fine-Tuning) 과정에서 두드러집니다. 범용 LLM을 특정 도메인에 맞춰 파인튜닝하면 해당 도메인의 성능은 올라가지만, 원래 잘 했던 다른 능력이 저하되는 현상이 빈번하게 관찰됩니다. 이 기존 지식의 망각 문제를 해결하기 위해 학습 데이터 설계, 정규화, 리플레이, 모듈 분리 등 이처럼 다양한 완화 기법이 존재하지만, 근본적인 해결에는 이르지 못하고 있습니다. 이것이 바로 Continual Learning이 단순한 학습 기법의 문제가 아니라, AI 아키텍처 자체의 재설계를 요구하는 이유입니다.

Catastrophic Forgetting이 Continual Learning을 어렵게 만든다

Continual Learning은 모델이 한 번의 학습으로 끝나는 것이 아니라, 새로운 정보를 계속 학습하면서도 기존 지식을 유지하는 것을 목표로 합니다. 인간에게는 자연스러운 이 능력이 AI에게 어려운 이유가 바로 Catastrophic Forgetting 때문입니다.

Google Research 연구진은 현재 LLM의 학습 구조를 뇌과학적으로 비유하면, '순행성 기억상실(Anterograde Amnesia)' 환자와 같다고 말합니다. 과거에 미리 훈련된 지식(사전학습 데이터)은 기억하고, 현재 입력으로 들어온 정보(컨텍스트)는 처리하지만, 새롭게 들어온 정보를 장기 기억(파라미터)으로 옮기지 못합니다. 매번 대화가 끝나면 방금 나눈 이야기를 잊어버리는 셈이죠.

허사비스는 이 문제에 대해 "기존 모델은 금붕어 뇌를 가지고 있다. 인터넷을 검색하고 정보를 찾아낼 수는 있지만, 모델 자체는 변하지 않는다."고 말했습니다. 즉, 현재의 LLM은 아무리 똑똑하더라도 대화에서 배운 것을 자기 자신의 지식으로 내재화하지 못한다는 뜻입니다.

이 문제를 해결하기 위한 연구가 바로 Continual Learning이며, 최근 Google에서 이 난제에 대한 새로운 접근법을 제시했습니다.

Google의 새로운 해법: Nested Learning

이 문제를 해결하기 위해 작년 11월, Google Research는 <Nested Learning: The Illusion of Deep Learning Architecture>라는 논문을 통해 Nested Learning이라는 패러다임을 제시했습니다.

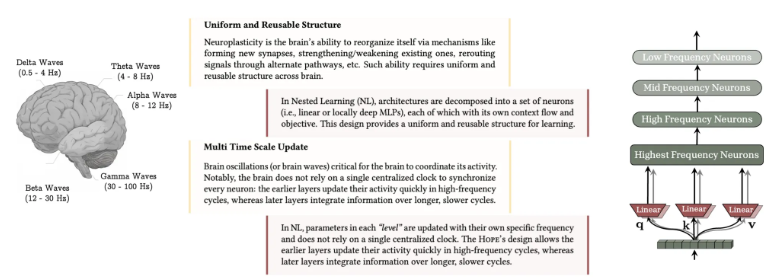

핵심 아이디어는 뇌의 기억 시스템에서 왔습니다. 뇌는 부위마다 정보를 처리하는 속도가 다릅니다. 해마는 밀리초(ms) 단위로 빠르게 변하며 단기 기억을 담당하고, 대뇌피질은 수면 중에 아주 천천히 변하며 장기 기억을 저장합니다. 이렇게 서로 다른 시간척도를 모델에 적용하여, 모든 변화를 하나의 파라미터 집합에 한 번에 반영하는 대신, 빠른 적응과 느린 통합을 분리하는 설계를 사용합니다.

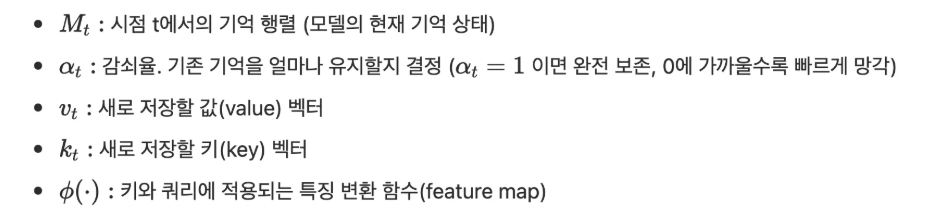

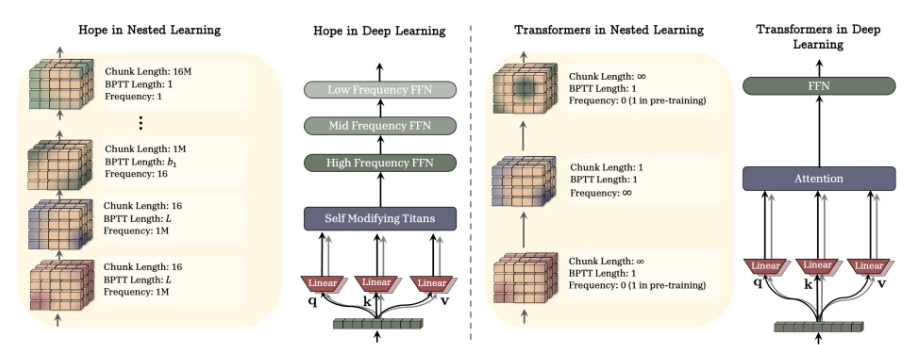

뇌가 감마파, 델타파처럼 빠른 파장과 느린 파장을 동시에 쓰듯, AI도 모델의 각 모듈도 서로 다른 시간 속도 차이를 이용해 정보를 학습합니다. 입력부(아래)의 빠른 뉴런은 데이터에 즉각 반응하고, 상위층(위)의 저주파 뉴런은 정보를 천천히 통합합니다. 출처: <Nested Learning: The Illusion of Deep Learning Architecture> (Behrouz et al., 2025)

기존 딥러닝이 모델 전체를 하나의 덩어리로 보고 한 번에 학습시켰다면, Nested Learning은 모델을 **'중첩된(Nested) 여러 최적화 문제의 집합’**으로 봅니다.

기존에는 모델을 딥러닝을 층이 쌓인 블록 하나로 보고, 이를 최적화 알고리즘으로 한 번에 학습시키는 방식을 사용해 왔습니다. 그러나 하나의 목적 함수를 최소화하는 단일 루프가 아니라, 연구진은 여러 개의 서로 다른 목적 함수가 계층적으로 연결된 구조로 보았습니다.

이 새로운 패러다임의 핵심은 마치 우리 뇌가 단기 기억과 장기 기억을 따로 관리하듯 모델 내부를 서로 다른 속도로 학습하는 루프들로 나누는 것입니다.

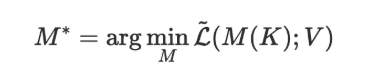

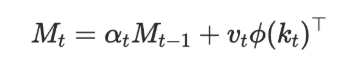

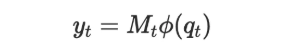

Nested Learning 논문은 이를 **연관 기억(Associative Memory)**이라는 관점에서 정의합니다. 키 집합 K를 값 집합 V에 매핑하는 연산자 M(⋅)을 학습하는 것이 핵심이며, 이 매핑의 품질을 측정하는 목적함수 L̃ 에 대해 다음과 같이 정의됩니다.

이 연관 기억이 실제로 작동하는 방식이 **Fast Weight Programmer(FWP)**입니다. 모델 안에 기억 행렬 M_t가 존재하고, 시점 t마다 새로운 데이터가 들어오면 이 행렬이 즉시 갱신됩니다.

그리고 저장된 기억이 필요할 때, 쿼리 q_t를 통해 검색(retrieval)합니다.

이 구조에는 두 가지 핵심 루프가 있습니다.

안쪽 루프(Inner Loop)는 데이터에 맞춰 모델이 스스로 변형됩니다. 기존의 딥러닝 모델은 학습이 끝나면 내부의 가중치(Parameter)가 고정된 상수(Constant) 상태였습니다. 입력 데이터가 무엇이든 똑같은 계산식을 적용했습니다. 하지만 Nested Learning의 안쪽 루프에서는 데이터가 들어오는 순간, 모델은 그 데이터가 가진 고유한 특징(문맥, 패턴, 통계적 분포)에 맞춰 이 특정 데이터를 가장 잘 처리할 수 있도록 임시 가중치(Fast Weights)를 즉각 수정합니다.

이는 추론이 곧 학습이 됨을 의미합니다. 보통은 학습과 추론이 분리되어 있지만, 여기서는 데이터를 처리하는 과정(추론) 중에 가중치를 수정하는 행위(학습)가 동시에 일어납니다. 즉, 모델은 "고정된 틀에 데이터를 끼워 맞추는 것이 아니라, 데이터에 맞춰 자신의 틀을 실시간으로 바꾸는 것"입니다.

바깥쪽 루프(Outer Loop)는 '변화하는 방법'을 학습합니다. 안쪽 루프가 매번 데이터에 맞춰 변한다면, 바깥쪽 루프는 “어떻게 변해야 효율적인가?”라는 학습의 규칙과 전체 데이터셋을 관통하는 보편적인 법칙을 학습하여 **장기 기억(Slow Weights)**에 저장합니다. 여기서 학습하는 것은 "새로운 데이터가 들어왔을 때, 안쪽 루프가 어떻게 반응해야 가장 효율적인가?" 하는 최적화입니다. 예를 들어, 어떤 초기값에서 시작해야 하는지, 가중치를 얼마나 빠르게 수정해야 하는지 등을 결정합니다.

결국 Nested Learning은 두 가지 최적화가 중첩(Nested)되어 돌아가는 구조입니다. 안쪽에서는 '현재의 데이터'를 가장 잘 설명하도록 임시 파라미터를 최적화하고, 바깥쪽에서는 '안쪽의 최적화 과정'이 잘 이루어지도록 영구 파라미터를 최적화하는 것이죠. 이 구조 덕분에 AI는 과거의 중요한 지식(바깥쪽 루프)을 훼손하지 않으면서도, 지금 눈앞에 있는 새로운 정보(안쪽 루프)를 받아들여 실시간으로 적응할 수 있게 되는 것입니다.

왜 이 방식이 '망각'을 막아주는가?

연구진은 이 이론을 검증하기 위해 Hope라는 아키텍처를 공개했습니다. Hope는 아래쪽 레이어가 높은 빈도로 빠르게 업데이트되어 문맥을 포착하고, 위쪽 레이어는 낮은 빈도로 장기 기억을 형성하는 계층적 구조를 갖추고 있습니다. 출처: <Nested Learning: The Illusion of Deep Learning Architecture> (Behrouz et al., 2025)

이 구조 덕분에 AI는 과거의 중요한 지식(바깥쪽 루프의 Slow Weights)을 훼손하지 않으면서도, 새로운 정보(안쪽 루프의 Fast Weights)를 받아들여 실시간으로 적응할 수 있게 됩니다. 새로운 데이터가 들어오면 Fast Weights가 그 충격을 흡수하고, Slow Weights는 천천히, 신중하게만 업데이트됩니다. 마치 뇌의 해마가 새 경험을 빠르게 기록하면서도, 대뇌피질의 장기 기억은 수면 중에 천천히 정리되는 것과 비슷하죠.

Continual Learning을 향한 또 다른 시도들

Nested Learning 외에도 '망각 없는 AI'를 만들기 위한 연구는 다각도로 진행되고 있습니다.

Titans는 Google이 2024년에 발표한 모델입니다. Nested Learning은 전체 구조를 뜯어고쳤다면 Titans은 트랜스포머 모델에 기억을 담당하는 신경망 메모리(Neural Memory)라는 별도의 기억 모듈을 달아준 것입니다. Nested Learning의 Hope 아키텍처는 이 Titans 모듈을 계층적으로 쌓아 올린 구조로 되어 있습니다.

Google은 이후 Titans에 MIRAS(Memory Identification, Retrieval, and Selection)라는 메커니즘을 추가했습니다. 기억 용량을 무작정 늘리면 쓸데없는 정보까지 다 기억하여 정작 중요한 정보를 찾기 힘들어지기 때문에, 중요하지 않은 정보는 무시하고 중요한 정보만 골라서 메모리에 업데이트하는 '문지기' 역할을 맡긴 것이죠.

Entropy-Adaptive Fine-Tuning(2026)은 또 다른 접근입니다. 무작정 모든 것을 배우는 게 아니라, 모델이 헷갈리는, 즉 엔트로피(Entropy)가 높은 부분만 골라서 업데이트하는 방식입니다. 이미 확실히 아는 지식은 건드리지 않고, 불확실한 정보만 수정하여 망각을 최소화합니다.

Continual Learning이 AGI로의 핵심일까?

AI 분야의 거장들은 공통적으로 Continual Learning을 AGI로 가는 길목에 반드시 놓여 있는 관문이라고 보고 있습니다.

허사비스는 "AGI에 도달하기 전에 아마도 한두 가지 큰 돌파구가 더 필요할 것"이라며, 그 방향으로 Continual Learning, 더 나은 메모리, 효율적인 컨텍스트 윈도우, 장기 추론과 계획 능력을 꼽았습니다. 그는 "뇌가 하는 것처럼 모든 것을 저장하지 말고, 중요한 것만 저장하는 것이 훨씬 효율적"이라며, AlphaZero에서 이미 좁은 도메인(게임)에서는 성공했지만 이를 현실 세계로 확장하는 것이 관건이라고 말했습니다.

카르파시 역시 작년 10월 팟캐스트에서 LLM의 한계를 짚었습니다. 모델 훈련 시점에 LLM 파라미터에 담긴 지식을 ‘흐릿한 잔상’이라 표현합니다. 인터넷 문서 15조 개의 토큰을 가져다가 수십억 개의 파라미터로 이루어진 최종 신경망으로 압축하기 때문에 엄청난 압축이 필요하고, 그래서 가중치 안에 있는 것은 1년 전 훈련 시에 읽은 것에 대한 흐릿한 잔상이라고 부른 것이죠. 또 모델 추론 시점에 컨텍스트 윈도우에서 일어나는 것은 모델이 직접적으로 접근할 수 있으니 ‘작업 기억(Working Memory)’이라고 말합니다. 그러나 세션이 끝나면 사라지는 근본적인 한계가 있습니다. 그는 인간이 수면 중 경험을 장기 기억으로 저장하듯, LLM에도 일어난 일을 집요하게 분석하고, 깊이 생각하고, 다시 가중치로 통합하는 ‘증류 단계’가 필요하다고 주장했습니다. 이런 Continual Learning, 멀티모달 능력, 컴퓨팅 능력 등 여러 문제가 해소되어야 진정한 에이전트가 가능하다고 보았습니다.

이 문제가 해결된다면 어떤 변화가 올까요? 가장 직접적으로는, AI 에이전트가 사용자와의 상호작용에서 스스로 진화할 수 있게 됩니다. 지금은 대화가 끝나면 모든 맥락이 사라지지만, Continual Learning이 가능한 AI는 사용자의 업무 패턴을 파악하고, 실수에서 배우고, 시간이 지날수록 더 정확한 판단을 내릴 수 있겠죠. 또한 모델 업데이트 비용도 극적으로 줄어듭니다. 현재는 새로운 지식을 반영하려면 수백만 달러 규모의 재학습이 필요하지만, Continual Learning이 실현되면 모델이 실시간으로 새로운 정보를 흡수할 수 있습니다.

하지만 넘어야 할 산은 아직 높습니다. 위스콘신-매디슨 대학의 ML 연구자 Sebastian Raschka는 "아직까지 Continual Learning에서 실질적인 돌파구가 나오지 않았다"라면서도, "이 분야가 뜨거운 주제인 만큼 향후 몇 년간 중요한 발전이 있을 것"이라고 전망했습니다. 한편으로는, Continual Learning이 1990년대부터 수십 년간 연구됐음에도 여전히 풀리지 않았다는 점에서 회의적인 시각도 존재합니다. 현재 AI 업계의 연구 자금 대부분이 모델 스케일링에 집중되어 있어, 이런 근본적인 문제에 대한 투자가 상대적으로 부족하다는 우려도 있습니다.

Continual Learning은 수십 년째 풀리지 않은 문제이고, 당장 해결될 것처럼 말하기엔 조심스럽습니다. 그래도 Nested Learning처럼 뇌의 기억 구조에서 실마리를 찾으려는 시도가 나오고 있고, 카르파시나 허사비스 같은 사람들이 이 문제를 정면으로 다루기 시작했죠. 이러한 흐름 속에서 관련 연구들이 어디까지 발전할지 지켜보는 것은 무척 흥미로운 일입니다.